A recuperação de informação (RI ou IR) é o processo de localizar dados específicos em coleções como sites, livros, vídeos ou outros documentos.

Esse processo é mais antigo do que imaginamos, sendo exercido muito antes do advento da computação. Hoje, porém, RI é um pilar essencial da web moderna, dos mecanismos de busca e de tudo o que envolve o acesso ao conhecimento digital.

O que motivou a escrita deste artigo foi a constatação de que a busca na internet vai muito além das estratégias de Search. A recuperação de informação é uma área que atravessa séculos e tecnologias. Mais do que uma disciplina técnica, ela acompanha a própria história do conhecimento humano.

Uma breve história da recuperação de informação

No século XVI, o volume de livros impressos já era considerado excessivo. Peter Burke e Asa Briggs (2006) mencionam que a explosão de informações após a invenção da prensa de Gutenberg gerou desafios sérios de organização e seleção de conteúdo. Um escritor italiano chegou a dizer, em 1550, que “há tantos livros que não temos nem tempo de ler os títulos”. A metáfora da floresta ou do oceano de livros era comum entre leitores da época.

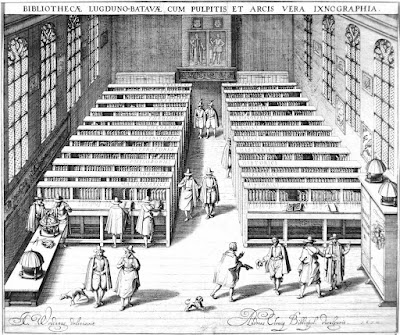

Com o passar dos séculos, os métodos de organização evoluíram: Gabriel Naudé propôs uma classificação por áreas do conhecimento nas bibliotecas, e a estrutura por categorias — como vemos em diretórios como o extinto DMOZ — já se manifestava em bibliotecas como a da Universidade de Leiden.

Assim, a recuperação de informação é anterior aos computadores. A diferença está no meio: antes feita por bibliotecários e catálogos físicos, hoje ocorre por meio de algoritmos sofisticados e agentes digitais.

Com a digitalização da informação e a popularização da internet, a RI ganhou uma nova dimensão. Tecnologias de cópia, armazenamento e distribuição (como CDs, pendrives e a nuvem) aumentaram exponencialmente a quantidade de informação disponível. A internet, em apenas cinco anos, atingiu o mesmo número de usuários que o rádio levou quase 40 anos para alcançar — um salto atribuído não só à infraestrutura tecnológica, mas à demanda por acesso rápido, flexível e remoto ao conhecimento.

É nesse contexto que surgem os mecanismos de busca.

Mecanismos de busca: automatizando a RI

Mecanismos como Google, Bing e outros buscadores têm como missão organizar e disponibilizar a vasta informação da web, tornando-a acessível em segundos. Se antes era preciso navegar por diretórios ou acessar site a site, hoje o processo é automatizado por robôs chamados crawlers ou spiders.

Esses sistemas se baseiam em agentes inteligentes, que atuam na web como ambiente. Segundo Russell e Norving (2004), um agente é qualquer programa que percebe seu ambiente e toma decisões com base em seus objetivos. No caso da RI, os spiders percorrem os links de páginas, coletam dados e os organizam em índices otimizados para pesquisa.

A estrutura conceitual de um mecanismo de busca pode ser dividida em:

- Spider (crawler): percorre a web em busca de novos conteúdos;

- Repositório de páginas: onde as páginas são temporariamente armazenadas;

- Indexador: extrai e organiza informações relevantes das páginas;

- Índice: banco de dados otimizado que armazena versões comprimidas e metadados das páginas;

- Módulo de pesquisa: interpreta a intenção da busca e procura por documentos relevantes;

- Módulo de ranking: avalia a relevância dos resultados com base em critérios como autoridade e conteúdo.

Ranking e relevância

O ranqueamento é o coração dos mecanismos de busca modernos. O Google, por exemplo, usa centenas de fatores — muitos dos quais desconhecidos do público — para determinar a ordem dos resultados. Fatores como presença da palavra-chave na URL, títulos, cabeçalhos, texto âncora de links e densidade semântica são fundamentais.

Além disso, há o critério de popularidade, que envolve a qualidade e quantidade de links recebidos por uma página. Isso simula a lógica das bibliotecas clássicas: os livros mais procurados são os mais conhecidos. Os sites mais referenciados (por links de qualidade) tornam-se, aos olhos dos mecanismos de busca, mais confiáveis.

Além dos mecanismos externos, a busca interna — dentro de websites — também é uma forma de recuperação de informação. Em e-commerces, por exemplo, o usuário pode navegar por categorias (como faria em um supermercado) ou buscar diretamente pelo nome de um produto. Essa interação exige que o site tenha uma arquitetura de informação clara e uma interface de busca eficiente.

A busca também ocorre de forma híbrida: ao pesquisar um produto, o usuário pode recorrer a mecanismos como Google, comparar preços em sites de marketplace e até verificar avaliações em redes sociais. A recuperação de informação, portanto, é multimodal, integrada e distribuída.

Inteligência artificial na RI moderna

A IA transformou radicalmente a recuperação de informação. Modelos como o BERT (Bidirectional Encoder Representations from Transformers), usados pelo Google, permitem interpretar o contexto das palavras e entender buscas com linguagem natural. Chatbots, sistemas de recomendação e ferramentas como ChatGPT, Gemini e Claude representam o novo patamar da RI, que hoje se aproxima da cognição humana.

Com a IA, é possível prever intenções, personalizar respostas e recuperar informações relevantes mesmo diante de perguntas vagas ou mal formuladas.

O futuro da RI está diretamente ligado à evolução dos mecanismos de busca, das tecnologias móveis, das redes sociais e da inteligência artificial. A tendência é que os sistemas se tornem cada vez mais naturais, personalizados e embutidos em nossas interações cotidianas — seja por voz, imagem ou texto.

Mas, apesar de toda essa sofisticação, a lógica básica permanece: buscar, filtrar e encontrar. A diferença é que agora isso ocorre em milissegundos, com suporte de bilhões de documentos, em múltiplos idiomas, dispositivos e contextos.

Considerações finais

Compreender a lógica da busca — online ou offline — é entender como a humanidade organiza e acessa o conhecimento. O SEO, por exemplo, é a prática moderna de otimizar esse processo dentro dos mecanismos de busca. Mas o raciocínio vai além: é preciso pensar como as pessoas procuram, onde procuram e como a tecnologia pode facilitar esse caminho.

A verdadeira performance digital está em saber transitar entre as mídias, respeitando a lógica da busca em cada uma delas.

Referências

- Burke, Peter. Uma história social do conhecimento: de Gutenberg a Diderot. Rio de Janeiro: Zahar, 2003.

- Burke, Peter; Briggs, Asa. Uma história social da mídia: de Gutenberg à Internet. Rio de Janeiro: Zahar, 2006.

- Cavalcanti, Marcos; Nepomuceno, Carlos. O conhecimento em rede: como implantar projetos de inteligência coletiva. Rio de Janeiro: Campus, 2007.

- Langville, Amy N.; Meyer, Carl D. Google’s PageRank and Beyond: The Science of Search Engine Rankings. Princeton University Press, 2006.

- Loveday, Lance; Niehaus, Sandra. Web Design for ROI: Turning Browsers into Buyers & Prospects into Leads. New Riders, 2008.

- Russell, Stuart J.; Norving, Peter. Inteligência Artificial. Rio de Janeiro: Elsevier, 2004.

- Santaella, Lucia. Linguagens líquidas na era da mobilidade. São Paulo: Paulus, 2007.

- Formaggio, Erick. SEO – Otimização de Sites – Aplicando técnicas de otimização de sites com uma abordagem prática. Rio de Janeiro: Brasport, 2010.

(Atualizado em 20/06/2025)